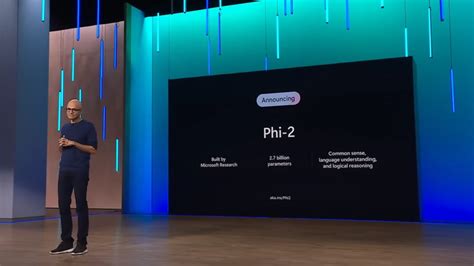

Microsoft, dil modelleri ve üretken yapay zeka (AI) alanındaki çabalarına bir yenisini ekleyerek Phi-2 adlı güçlü küçük dil modelini tanıttı. Bu önemli adım, Azure AI Studio şablon kataloğunda kullanıcıların erişimine sunulan Phi-2 ile sektördeki dil modeli geliştirmelerine yeni bir boyut kazandırıyor.

Phi-2, 2,7 milyar parametre içeren kompakt bir dil modeli olarak dikkat çekiyor. Önceki versiyonu Phi-1,5‘ten önemli ölçüde daha büyük olan bu model, 13 milyardan az parametre ile karmaşık kıyaslama testlerinde benzerlerinden 25 kata kadar daha iyi performans sergiliyor.

Microsoft’un yaptığı açıklamaya göre, Phi-2 modeli, Meta’nın Mistral’ın Llama-2 modelleri ve Google’ın Gemini Nano 2 gibi büyük dil modelleriyle karşılaştırılabilir performans gösteriyor. Ancak Phi-2‘nin avantajı, daha küçük boyutu ve daha az parametresiyle bu performansı sağlaması.

Phi-2‘nin eğitimi sırasında Microsoft, el yazısı kalitesi verilerini kullanarak başladı ve daha sonra seçkin web verilerini ekleyerek veritabanını zenginleştirdi. Şirket, bu yaklaşımın SLM’lerin (Küçük Dil Modelleri) uygun maliyetli alternatifler olduğunu ve daha az karmaşık görevler için ideal olduklarını gösterdiğini vurguluyor.

Daha da önemlisi, SLM’lerin çalıştırılması için gereken bilgi işlem gücünün LLM’lere (Büyük Dil Modelleri) göre daha düşük olması, kullanıcıların pahalı GPU’lara yatırım yapmadan veri işleme ihtiyaçlarını karşılamasına olanak tanıyor. Microsoft’un Phi-2 modeli, bu alanda yeni bir döneme işaret ederken, daha küçük boyutlu dil modellerinin de etkileyici performans gösterebileceğini kanıtlıyor. Bu gelişme, dil modeli teknolojisinin geleceğine yeni bir perspektif katıyor.