24 Haziran 2024Haber odasıGüvenlik Açığı / Yapay Zeka

Google, adında yeni bir çerçeve geliştirdi. Proje Uyku Zamanı Bu, otomatik keşif yaklaşımlarını geliştirmek amacıyla büyük bir dil modelinin (LLM) güvenlik açığı araştırması yürütmesine olanak sağladığını söylüyor.

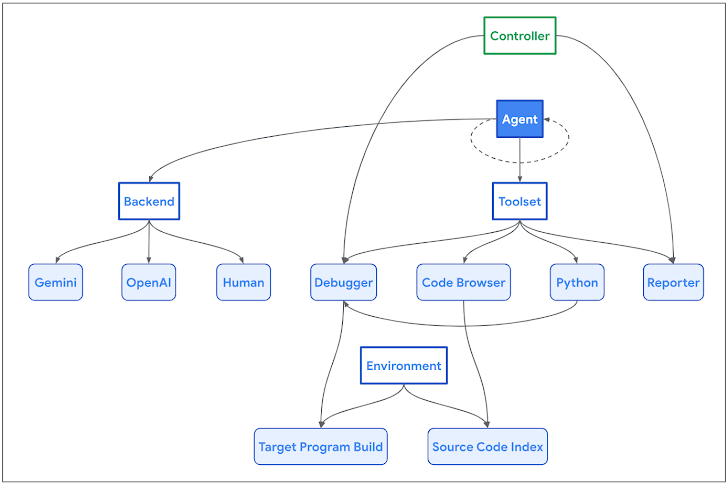

Google Project Zero araştırmacıları Sergei Glazunov ve Mark Brand, “Naptime mimarisi, bir yapay zeka aracısı ile hedef kod tabanı arasındaki etkileşime odaklanıyor.” söz konusu. “Ajan, bir insan güvenliği araştırmacısının iş akışını taklit etmek için tasarlanmış bir dizi özel araçla donatılmıştır.”

Girişim, güvenlik açığı araştırmasına ve değişken analizinin otomatikleştirilmesine yardımcı olurken aynı zamanda insanların “düzenli olarak şekerleme yapmasına” olanak sağlaması nedeniyle bu adı almıştır.

Bu yaklaşım, özünde, LLM’lerin kod anlama ve genel muhakeme yeteneğindeki ilerlemelerden yararlanmayı ve böylece güvenlik açıklarını belirleme ve gösterme konusunda insan davranışını kopyalamalarına olanak sağlamayı amaçlamaktadır.

AI aracısının hedef kod tabanında gezinmesini sağlayan bir Kod Tarayıcı aracı, fuzzing için sanal alan ortamında Python komut dosyalarını çalıştırmak için bir Python aracı, farklı girişlerle program davranışını gözlemlemek için bir Hata Ayıklayıcı aracı ve bir Raporlayıcı gibi çeşitli bileşenleri kapsar. Bir görevin ilerlemesini izlemek için kullanılan araç.

Google, CYBERSECEVAL 2 kriterlerine göre Naptime’ın aynı zamanda modelden bağımsız ve arka uçtan bağımsız olduğunu, ayrıca arabellek taşmasını ve gelişmiş bellek bozulması kusurlarını işaretlemede daha iyi olduğunu söyledi. Meta’dan araştırmacılar tarafından bu Nisan ayı başlarında yayınlanan CYBERSECEVAL 2, bir değerlendirme paketi LLM güvenlik risklerini ölçmek için.

Arama devinin kusurları yeniden oluşturmak ve kullanmak için gerçekleştirdiği testlerde, iki güvenlik açığı kategorisi OpenAI GPT-4 Turbo için sırasıyla 0,05 ve 0,24’ten 1,00 ve 0,76’ya yükselen yeni en yüksek puanlara ulaştı.

Araştırmacılar, “Naptime, bir LLM’nin, insan güvenliği uzmanlarının yinelemeli, hipoteze dayalı yaklaşımını yakından taklit eden güvenlik açığı araştırması gerçekleştirmesine olanak tanıyor” dedi. “Bu mimari, aracının yalnızca güvenlik açıklarını belirleme ve analiz etme yeteneğini geliştirmekle kalmıyor, aynı zamanda sonuçların doğru ve tekrarlanabilir olmasını da sağlıyor.”

siber-2