Avrupa Parlamentosu, yapay zekaya ilişkin Avrupa mevzuatını (AI Yasası) yeni kabul ederken, Stanford Üniversitesi’nden bir araştırma ekibi, ana …

Avrupa Parlamentosu, yapay zekaya ilişkin Avrupa mevzuatını (AI Yasası) yeni kabul ettiğinden, Stanford Üniversitesi’nden bir araştırmacı ekibi, dil modellerinin ana tedarikçilerinin gereksinimleri karşılayıp karşılamadığını belirlemeye çalıştı. Onların sonuçlar hala sahip olduklarını göstermek büyük çaba gösterilecek.

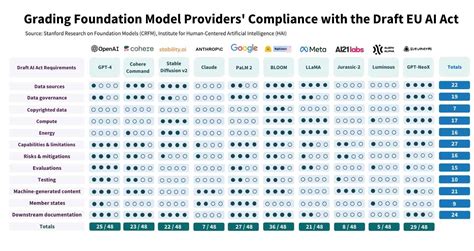

Hiçbir dil modeli tamamen AI Yasası ile uyumlu değildir

AB, AI düzenlemesinde dünya lideri olmayı hedefliyor ve metninin dünyanın geri kalanı için bir standart haline geleceğini düşünüyor. Bu, OpenAI veya Google gibi model sağlayıcılar için açık yükümlülükler sağlar. Örnekler, model eğitimi sırasında telif hakkıyla korunan eğitim verilerinin, kullanılan materyallerin ve üretilen emisyonların kullanımını ve yapay zekaların nasıl değerlendirilip test edildiğini içerir.

Stanford Üniversitesi’nin İnsan Merkezli Yapay Zeka programından araştırmacılar, büyük satıcıların AI Yasası yürürlüğe girdiğinde (muhtemelen 2024’te) hazır olup olmadığını belirlemek için analiz etti. modellerinin metnin yükümlülüklerine uyup uymadığı. Mevzuatta belirtilen 22 şarttan 12’sini seçip, halihazırda piyasada bulunan on model için her birine dört üzerinden bir puanlama sistemi uyguladılar. Özellikle OpenAI’den GPT-4’ü, Google’dan PaLM 2’yi ve hatta Meta’dan LLaMA’yı buluyoruz.

Bir modelin alabileceği en yüksek puan 48’dir. BigScience’ın AI Bloom’u 36 puanla listenin başında yer alırken, onu GPT-NeoX ve PaLM 2 takip ediyor. GPT-4, 48 üzerinden 25 puanla dördüncü sırada yer alıyor.

Infographics: Stanford Üniversitesi.

Şeffaflığa odaklanın

” Sonuçlarımız ortaya çıkıyor Uyumluluk konusunda model sağlayıcılar arasında çarpıcı bir boşluk “diyor araştırmacılar. Tüm iç denetimler tarafından en az karşılanan gereksinimler, telif hakkı, enerji tüketiminin raporlanması, risk azaltma veya azaltmamanın yetersiz ifşası ve ekosistemi değerlendirmek için denetimin ifşa edilmemesini kapsayan gereksinimlerdir.

” Temel model satıcıları, model performansını kötü amaçlı kullanım gibi kasıtlı zarar veya sağlamlık ve kalibrasyon gibi faktörler açısından nadiren ölçer. “, çalışmayı not ediyor.

Modellerin hiçbiri mükemmel bir puan alamamış olsa da, araştırmacılar büyük ölçüde iyileştirme fırsatı. “ Bunu düşündükyeterli şeffaflık veri, hesaplama ve diğer faktörler için yasal gereklilikleri karşılamak üzere, model sağlayıcıların toplu olarak endüstri standartları veya düzenlemelerinden kaynaklanan eylemlerde bulunması durumunda ticari olarak uygulanabilir olmalıdır. “, Onlar yazar.

Ayrıca ilgili şirketler ve yasa koyucular için bir tavsiye listesi hazırlarlar. Örneğin, dil modeli satıcılarına, aşağı akış modellerine güvenen geliştiricilerin kullanabileceği belgeleri geliştirmelerini tavsiye ederler. Araştırmacılar, Microsoft Başkanı Brad Smith ve OpenAI CEO’su Sam Altman tarafından zaten yapılmış bir talep olan yapay zeka için endüstri çapında standartlara duyulan ihtiyacı özellikle vurguluyorlar.